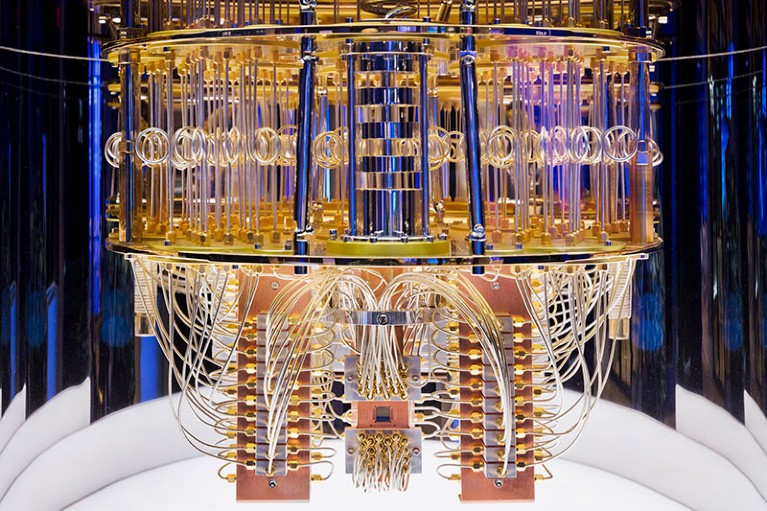

IBM的内部量子计算机显示线缆用来控制和读出它的量子位。信贷:IBM

IBM最新的量子计算芯片,11月15日披露,建立了各种各样的里程碑:127年包量子位(量子比特),成为第一个这样的设备达到三位数。但成就只有一个步骤在一个积极的议程受到整个行业的数十亿美元的投资。

“鹰”芯片是一个一步IBM的目标创建一个明年433 -量子位的量子处理器,紧随其后的是一个有1121个量子位,名叫秃鹫,到2023年。这样的目标回波那些几十年的电子行业设定小型化硅芯片,Jerry Chow说,IBM的实验量子计算组主管托马斯·沃森研究中心,位于纽约。

其他公司,包括技术巨头Google和霍尼韦尔,和大量的资金充足的创业公司——同样雄心勃勃的计划。最终,他们的目标是使量子计算机能够执行特定任务的遥不可及甚至最大的超级计算机,使用经典的技术。

“很高兴有雄心勃勃的目标,但重要的是他们是否能执行他们的计划,“说量子信息理论家约翰Preskill在帕萨迪纳市加州理工学院的。

量子的优势

利用量子物理定律来处理二进制信息,量子计算电路如鹰芯片已经可以计算,不能很容易地模拟经典超级计算机。谷歌曾实现这样一个量子的优势“2019年1,用量子位,像IBM,超导循环。团队在中国科学技术大学在合肥科大去年报道实现使用光学量子比特量子优势2;今年,它与超导量子比特做了同样的事情3。

但是这些机器是人工任务,研究人员警告。“当前状态的艺术是没有实际任务的实验表明量子优势,”物理学家说朝阳路,共同科大努力。解决现实世界的问题,如模拟药物分子或材料使用量子化学要求量子计算机将大大更大、更强大。

量子工程师Andrew Dzurak悉尼新南威尔士大学,澳大利亚,认为与1000 -量子位芯片如IBM计划的秃鹫,这项技术可能会证明它的价值。“这是希望一些有用的,甚至是有商业价值的问题可以解决使用量子计算机在这个thousand-to-million-qubit范围内,”他说。“但是真的做一些东西,你需要数百万物理量子位元。”

芯片的挑战

鹰芯片几乎两倍的量子位作为IBM之前的旗舰量子电路、65 -量子位蜂鸟。需要增加团队解决一些工程问题,Chow说。使每个量子位与其他几个人,研究人员选择了一个安排,每一个与两个或三个邻国六角网格。并允许单独控制每个量子位没有电线的难以管理混乱,团队把电线和其他组件放在几个堆叠层。Chow说,为了解决这个“包装”问题,研究人员利用3 d体系结构在常规芯片的经验。他补充说,这也是发现的关键材料,使之能够很好地运行在超低温度所需的超导量子比特的功能。

但量子电路的处理能力不仅仅是多少量子位。这也取决于他们运作和如何抵抗多快可以争夺一个计算错误,例如由于随机波动。Chow说,在所有这些方面仍有改进的余地超导量子比特。

处理错误是特别困难的,因为物理定律阻止量子计算机使用的纠错方法经典机器,通常需要让每一位的多个副本。

相反,研究人员致力于构建“逻辑量子位元”——几乎所有的错误都可以被识别并纠正了许多物理量子位的——从复杂的安排。程序到目前为止提出了一般要求每个逻辑量子位包含大约1000个物理量子位,尽管这一比例取决于内在的忠诚——error-resistance物理量子位,Dzurak说。

误差修正

一些其他的方法来建立量子计算机希望受益于较低的量子比特内在的错误率。这是一个使用困离子量子位的潜在优势,是由该公司IonQ,失去研究马里兰大学学院公园,上月提高了超过6亿美元,成为第一个纯粹量子计算公司在纽约证券交易所公开上市交易,交易市值达到了近20亿美元。Rigetti计算,启动在伯克利,加州也上市,今年1.5美元的估值。

IonQ创始人克里斯托弗·梦露,马里兰大学的物理学家,和他的同事上月公布一个容错逻辑量子位仅由13捕获离子量子位4尽管Dzurak表示,其程度的纠错”仍然很长一段路需要从一个有用的量子计算机,需要逻辑出错率低于一百万分之一”。

与此同时,谷歌团队取得了类似的逻辑使用21超导量子比特错误率5:,“一个重要的结果”,说Dzurak,但仍然远离裂纹需要纠错的问题。

但周润发也警告称,不应过于强调实现逻辑量子位。“我们不会有情况翻转开关,说纠错是”,他说。“改善量子位性能比制造一个更重要的故事逻辑量子位和一切除以1000。”

信号增强

IBM和其他公司正试图获得详细的错误理解电路噪声,然后提取,而像降噪在声学提高信噪比。

Chow说,除了Condor-level设备,电路设计有可能成为模块化,与几个芯片通过“量子互联”有关。尚不清楚如何做到这一点——也许与目前使用的微波频率信号数据输入和输出超导量子比特,或者通过将量子信息转换为光学信号。“这是一个全新的研究领域,”Chow说。

许多研究者认为量子计算机的第一真实世界的应用程序可能会在相对专业的领域,如分子模拟和材料,包括金融行业的机器学习和优化问题。到那个阶段,“我期望我们将会看到逐步改善性能而不是突然的飞跃”,Preskill说。“这可能是一个漫长的跋涉才能运行有用的应用程序。”

量子计算机竞赛加剧作为替代技术获得蒸汽

量子计算机竞赛加剧作为替代技术获得蒸汽 你好量子世界!谷歌发布里程碑式的量子霸权索赔

你好量子世界!谷歌发布里程碑式的量子霸权索赔 除了量子霸权:寻找有用的量子计算机

除了量子霸权:寻找有用的量子计算机