2020年2月,随着COVID-19在全球迅速传播,抗原检测很难获得,一些医生转向人工智能(AI)来尝试诊断病例1.一些研究人员让深度神经网络(擅长发现图像中微妙模式的复杂系统)查看x光片和胸部计算机断层扫描(CT)扫描,以快速区分患有covid - 19肺炎的人和没有患肺炎的人2.西雅图华盛顿大学的计算机工程师亚历克斯·德格雷夫说:“在COVID-19大流行的早期,人们竞相制造工具,尤其是人工智能工具来帮助解决问题。”但在这种匆忙中,研究人员没有注意到许多人工智能模型已经决定走一些捷径。

人工智能系统通过分析被标记为covid - 19阳性或阴性的x射线来磨练自己的技能。然后,他们将利用他们在图像之间发现的差异来推断新的、未标记的x射线。但是有一个问题。“当时没有很多可用的数据,”德格雷夫说。

自然展望的一部分:机器人和人工智能

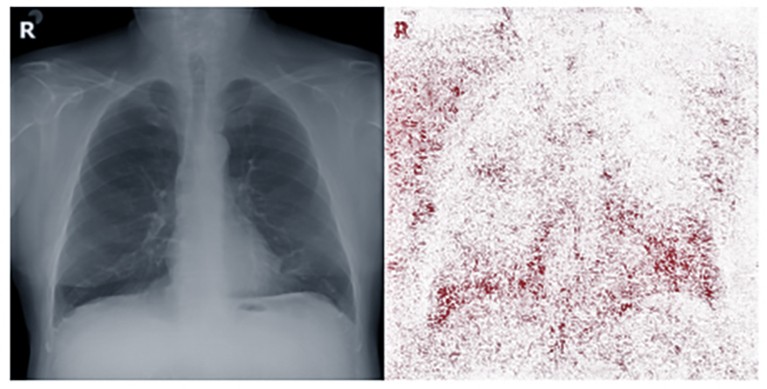

他解释说,一些医院正在发布COVID-19患者的x光片。与此同时,对没有感染COVID-19的人的扫描主要来自美国国立卫生研究院(nih)在大流行前收集的肺部图像库。因此,数据集具有特征差异,与一个人是否患有这种疾病无关。例如,许多x光片使用字母R来标记人的右侧,因此放射科医生在看图像时可以正确地定位。然而,这些标记物的外观因医院而异。由于大多数covid - 19阴性图像来自单一来源,一些以这种方式训练的人工智能系统的诊断不仅基于显示的生物学,还基于x射线上字母R的风格和位置。

DeGrave和Joseph Janizek都是计算机科学家Su-In Lee在西雅图生物和医学科学可解释人工智能实验室的成员,他们发表了一篇论文3.在自然机器智能在2021年5月报告了这个问题。机器学习模型的决策过程通常被称为黑盒——研究人员和用户通常知道输入和输出,但很难看到里面发生了什么。但DeGrave和Janizek能够打开这些盒子,使用旨在测试人工智能系统的技术,并解释它们为什么会这样做。

人工智能系统用于指导COVID-19诊断的x射线部分(红色像素)包括标记患者右侧的字母。信贷:a·布斯托斯et al。医学影像肛门。66, 101797 (2020)

构建可解释的AI(有时称为XAI)有许多优点。在医疗环境中,了解一个系统做出某种诊断的原因可以帮助病理学家相信它是合法的。在某些情况下,法律要求解释:例如,当一个系统对贷款资格作出决定时,美国和欧盟都要求提供证据,证明如果信贷被拒绝,不是由于法律禁止的原因,如种族或性别。对人工智能系统内部工作原理的深入了解还可以帮助计算机科学家改进和完善他们创建的模型,甚至可能导致关于如何解决某些问题的新想法。然而,只有当XAI给出的解释本身是可理解和可验证的,并且构建模型的人认为这是一项有价值的努力时,XAI的好处才能实现。

任何其他名称的神经元

DeGrave和Janizek所研究的深度神经网络已经变得很受欢迎,因为它们具有神奇的能力,可以通过暴露来了解照片中的内容、口语的含义等等。这些网络的工作方式与人脑类似。就像某些活的神经细胞对外部刺激的反应是有规律的一样——例如,看到猫会引发与看到树不同的模式——神经网络中的人工神经元会根据它们接收到的输入产生特有的反应。

订阅《自然》杂志关于机器人和人工智能的通讯

这里的神经元是数学函数。输入数据以数字形式进入系统,例如,描述照片中像素的颜色。然后神经元对这些数据进行计算。在人体中,神经元只有在接收到的刺激超过一定的电阈值时才会发出信号。类似地,人工神经网络中的每个数学神经元都用阈值进行加权。如果计算结果超过该阈值,则将其传递到另一层神经元进行进一步计算。最终,系统会学习统计模式,了解输出数据与输入数据之间的关系。被标记为有猫的图像将与那些被标记为没有猫的图像存在系统差异,然后可以在其他图像中寻找这些泄露性迹象,以确定有猫存在的概率。

在神经网络以及其他机器学习技术的设计中存在变化。一个模型对一个输入应用的计算层越多,它就越难以解释它在做什么。马萨诸塞州波士顿大学的计算机科学家凯特·萨安科(Kate Saenko)说,一些简单的模型,比如小型决策树——它会权衡一些相互竞争的选择,从而得出不同的答案——并不是真正的黑匣子。她说,小型决策树“基本上是一组规则,人类可以很容易地理解模型在做什么,所以它本质上是可解释的”。然而,深度神经网络通常太复杂了,我们很难轻易理解。Saenko说:“神经网络正在进行的计算涉及数百万,现在更可能是数十亿个数字。”

映射的活动

一般来说,试图解释深度神经网络的神秘工作原理包括找出输入数据的哪些特征会影响结果,并利用这些特征来推断黑盒内发生的事情。帮助DeGrave和Janizek发现胸部x光片上的方向标记会影响诊断的一个工具是显着图——一种颜色编码的图表,显示计算机在做出判断时最关注图像的哪一部分。

Saenko和她的同事开发了一种叫做D-RISE(探测器随机输入抽样解释)的技术来制作这样的地图4.研究人员拍摄一张照片——例如,一个装满鲜花的花瓶——并系统地屏蔽图像的不同部分,然后将其展示给人工智能,以识别特定物体,如花瓶。然后,他们记录下模糊每一簇像素如何影响结果的准确性,并告诉系统根据每个部分对识别过程的重要性对整张照片进行颜色编码。

亚历克斯·德格雷夫和约瑟夫·贾尼泽克是西雅图华盛顿大学医学家培训项目的学生。图源:Alex DeGrave

不出所料,在一张充满鲜花的花瓶的照片中,花瓶本身被明亮的红色和黄色照亮——它的存在很重要。但这并不是图片中唯一被突出显示的区域。萨延科说:“这种显著性一直延伸到花束上。”“它们没有被标记为花瓶的一部分,但模型知道,如果你看到花,这个物体更有可能是花瓶。”

D-RISE强调了一些因素,如果去掉这些因素,会导致AI模型改变其结果。Saenko说:“这有助于了解他们可能会犯什么错误,或者他们是否出于错误的原因而做某事。”Saenko在这一领域的工作部分得到了美国国防高级研究计划局(Defense Advanced Research Projects Agency)现已完成的XAI项目的资助。

修改输入数据以识别重要特征是许多类型人工智能模型的基本方法。但宾夕法尼亚州匹兹堡市卡内基梅隆大学的计算机科学家Anupam Datta说,在更复杂的神经网络中,这项任务变得更具挑战性。在这些复杂的情况下,科学家们不仅想要梳理出哪些特征在决策中起作用,以及这种作用有多大,还想要梳理出一个特征的重要性是如何随着其他特征的变化而变化的。“因果因素仍然存在,因为我们仍然试图找出哪些特征对模型的预测有最高的因果影响,”Datta说。“但测量它的机制发生了一些变化。”与萨延科的显著性地图一样,他系统地屏蔽了图像中的单个像素。然后,可以为图像的这一部分分配一个数学值,表示由于模糊该部分而导致的变化的大小。看到哪些像素是最重要的,Datta就会知道隐藏层中的哪些神经元对结果的影响最大,这有助于他绘制模型的内部结构,并就模型所学的概念得出结论5.

解释的进步

DeGrave和Janizek测量显著性的另一种方法依赖于一种被称为生成对抗网络(GAN)的复杂类型的神经网络。典型的GAN由一对网络组成。一个生成数据——例如街道的图像——另一个试图确定输出是真还是假。

两个网络继续以这种方式交互,直到第一个网络可靠地创建了可以欺骗另一个网络的图像。在他们的案例中,华盛顿的研究人员要求GAN将covid - 19阳性的x射线转化为covid - 19阴性图像3..通过观察它改变了x射线的哪些方面,研究人员可以看到计算机认为图像的哪些部分对其诊断是重要的。

虽然GAN的基本原理很简单,但对网络的微妙动态还没有很好地理解。“GAN生成图像的方式相当神秘,”位于剑桥的麻省理工学院的计算机科学家安东尼奥·托拉尔巴(Antonio Torralba)说,他正在试图解开这个谜。给定一个随机的数字输入,它最终输出一个看起来真实的图片。这种方法已经被用来创建不存在的面孔的照片,并产生读起来好像是由一个人写的新闻故事。

Torralba和他的团队决定解剖GAN,看看单个神经元在做什么。和Datta一样,他们发现一些神经元专注于特定的概念6.他说:“我们发现一些小组负责画树,另一些小组负责画建筑物,还有一些小组负责画门窗。”就像萨延科的模型知道花朵意味着花瓶一样,他的GAN中的单元也从上下文中学习。其中一人开发了一种床探测器,可以判断一个场景是否是卧室,另一人了解到门通常不存在于树上。

一个显示花瓶中的花朵的显著性地图,帮助人工智能系统检测花瓶本身。来源:MS COCO数据集

Torralba说,能够识别哪些神经元正在识别或产生哪些物体,这为改进神经网络提供了可能,而不必向它展示数千张新照片。如果一个模型已经被训练来识别汽车,但它所训练的所有图像都是在铺好的表面上行驶的汽车,那么当它看到汽车在雪地上行驶的图像时,它可能会失败。但是,了解模型内部联系的计算机科学家可能能够调整模型,将一层雪识别为等同于铺设的表面。类似地,计算机特效设计师如果想要自动创建一个不可能的场景,可以手工重新设计模型来实现这一点。

可解释性的另一个价值是,机器执行任务的方式可能会为观看它的人提供一些见解,让他们知道自己如何能以不同的方式或更好地完成任务。计算生物学家Laura-Jayne Gardiner训练人工智能来预测哪些基因在调节生物钟中起作用,生物钟是控制一系列生物过程的内部分子计时器7.Gardiner和她在IBM欧洲研究院和Earlham研究所(英国诺维奇的一个生命科学研究小组)的同事们还让计算机突出了它用来决定基因是否可能在昼夜节律中发挥作用的特征。它的做法令人惊讶。加德纳说:“我们只关注基因调控的启动子,”但人工智能在基因序列中发现了研究人员会忽略的线索。Gardiner解释道:“你最终会得到这些功能的排名列表;该团队可以在实验室研究中使用这一点,进一步完善对生物学的理解。

准确和信任

卡耐基梅隆大学(Carnegie Mellon University)的计算机科学家普拉迪普·拉维库玛(Pradeep Ravikumar)说,提出解释是一个开始,但也应该有一种方法来量化它们的准确性。拉维库玛正在研究如何将这种评估自动化8.对人类来说似乎有意义的解释实际上可能被证明与模型实际做的事情没有什么关系。

“如何客观评估解释的问题仍处于早期阶段,”拉维库玛说。“我们需要更好的解释,也需要更好的方法来评估解释。”测试解释准确性的一种方法是对解释中认为重要的特征做一些小的改变。如果确实如此,这些输入中的微小变化应该会导致输出中的巨大变化。类似地,对不相关特征的大改动——比如,从猫的图片中删除公交车——不应该影响结果。如果评估系统更进一步,不仅预测哪些特征是重要的,而且还预测如果对这些特征做出微小的改变,模型的答案将如何变化,这也可以被测试。拉维库玛说:“如果一种解释实际上是在解释模型,那么它就会更好地了解模型在这些小变化下的表现。”

寻找解释有时似乎是一项艰巨的工作,以至于许多计算机科学家可能会被诱惑跳过它,只看人工智能的结果。但至少某种程度上的解释是相对简单的——例如,显著性地图现在可以快速而廉价地生成,Janizek说。相比之下,训练和使用GAN更加复杂和耗时。贾尼亚泽克说:“你必须非常熟悉深度学习的东西,并有一台带有图形处理单元的好机器才能让它工作。”他的团队尝试的第三种方法——用照片编辑软件手动修改几百张图片,以确定某个特征是否重要——甚至更加劳动密集型。

一种被称为生成对抗网络(GAN)的神经网络可用于生成新图像,例如通过添加草和树。来源:David Bau

Saenko说,机器学习社区的许多研究人员也倾向于在可解释性和准确性之间进行权衡。他们认为,使神经网络比小型决策树更准确的细节水平和计算数量,也使它们超出了所有人类的理解范围。但Janizek说,有些人质疑这种权衡是否真实。“最终情况可能是,一个更可解释的模型是一个更有用的模型,也是一个更准确的模型。”

他补充说,神经网络可以识别出的一些人类无法察觉的模式,似乎并不像计算机科学家曾经认为的那么重要。“它们有多少次是真正具有预测性的,能够在各种环境中推广?”它们有多频繁地发出某种特定来源的奇怪噪音?”

更多信息来自《自然展望》

拉维库玛说,无论可解释性的挑战是大是小,一个好的解释并不总是足以说服用户依赖一个系统。了解亚马逊(Amazon) Alexa等人工智能助手以某种方式回答问题的原因,可能不会像禁止滥用私人谈话录音的法律那样,在用户之间建立信任。也许医生们将需要临床证据来证明计算机的诊断是正确的,以及一个经过验证的生物学原因来证明计算机所观察的因素应该是相关的。政策制定者可能会要求将有关使用此类系统的一些保护措施写入法律。拉维库玛说:“这些都是更广泛的问题,我认为社区并没有真正深入思考。”

然而,在解释领域,人工智能研究人员已经取得了长足的进步。Torralba说,尽管可能仍有一些细节需要解决,以涵盖各种正在使用的机器学习模型,但这个问题将在一两年内得到解决。他说,人们“总是谈论这个黑盒子,但我们不认为神经网络是黑盒子。如果他们工作得很好,那么如果你仔细观察,他们所做的是有意义的。”

微型医疗机器人从科幻小说中脱颖而出

微型医疗机器人从科幻小说中脱颖而出 教机器人触摸

教机器人触摸 终生学习

终生学习 仿生机器人会走路、游泳、滑行和飞行

仿生机器人会走路、游泳、滑行和飞行