摘要

从图像局部显著区学习辨别视觉模式被广泛应用于细粒度视觉分类任务,如植物或动物物种分类。大量的复杂网络被设计用于学习判别特征表示。本文提出了一种新的FGVC局部结构信息(LSI)学习方法。首先,我们指出现有的FGVC方法没有充分考虑如何从输入图像中提取LSI。然后介绍了一种大规模集成电路提取技术,该技术能够正确地描述图像中不同局部结构特征的性质。其次,在给定的骨干网中加入新的LSI学习模块,提高骨干网发现显著区域的能力;第三,大量的实验表明,我们提出的方法在六个图像数据集上取得了更好的性能。特别是,所提出的方法在图像数量有限的数据集上表现得更好。

简介

在计算机视觉和图像处理中,目标分类是非常重要的。近年来,细粒度视觉分类(FGVC)研究取得了持续稳定的进展。一方面,很多深度神经网络1,2,3.,4,5,6,7,8随着学习能力的提高,可以识别高度相似物体之间的细微差别。另一方面,大量的细粒度图像数据集,包括鸟类物种9、汽车10、飞机11、超细粒度(UFG)12,由领域专家收集。在这些数据集中,复杂规则被用来衡量对象分类方法的准确性,也有利于改进更好的算法。

FGVC的关键步骤是从显著区域学习判别信息。现有的FGVC方法分为两类。第一组方法13拟优化神经网络结构,从显著区域学习判别信息。第二组的方法14尝试通过边界框或部分注释机制来定位突出区域15,16,17然后利用所选区域的判别信息进行目标分类。

我们知道,从每个输入图像中提取(局部结构信息)LSI是FGVC的基本步骤。目前,大量的大规模集成电路提取技术如一阶导数和二阶导数18,19已经被求婚了。此外,图像数据增强技术被广泛用于提高LSI提取的效率,以更好地找到鉴别区域,提高FGVC的性能,包括20.,图像旋转21,图像翻转5,7,22,图像仿射变换23.然而,在我们的研究范围内,在FGVC领域,还没有人系统地研究如何正确地描绘每个输入图像中的不同局部结构特征(例如,边缘,角和斑点)进行对象分类。原因是他们没有考虑如何从每个输入图像中正确提取LSI,也没有考虑不同类型图像局部结构特征的性质及其之间的差异。例如,Feng等人。21打算使用原始图像和旋转图像(例如,逆时针旋转原始图像\π(\ \)/ 2,\π(\ \),和3\π(\ \)/2)增强特征学习能力。然而,这是最近发生的事24,25演示了LSI之间的图像和图像旋转\π(\ \)都是一样的。

本文研究了一阶和二阶方向导数25,26,27,28,29,30.,31,32,33,34,35利用图像局部结构特征的特征特性,研究现有的大规模集成电路提取、图像数据增强和局部结构特征描述技术。我们的研究表明,现有的图像数据增强技术(例如,光照变化36,图像着色20.,图像仿射变换23)对FGVC的性能有很大影响。现有的图像数据增强技术如果没有仔细考虑从每个输入图像中提取LSI和描述局部结构特征,就不能有效地增强网络从每个输入图像中提取LSI的能力,从而导致FGVC的稳定性问题,甚至削弱FGVC的性能。上述现象在无监督的情况下更容易发生。同时,边、角和斑点的一阶和二阶方向导数表明,有必要沿多个滤波方向提取局部结构特征的LSI。只有这样,我们才能正确地获得具有不同局部结构特征的LSI。

在这项工作中,我们提出了一种新的用于FGVC的LSI学习方法。沿多个滤波方向提取图像LSI的思想和注意增强机制(AEM)的思想37相结合,有效地从每个输入图像中提取LSI,并自动对FGVC的显著区域进行定位。为了防止过拟合和噪声的影响,本文提出的方法除了从每个输入图像中充分提取LSI外,不需要额外的辅助条件。此外,该方法还考虑了目标的整体结构信息。

我们提出的方法的主要贡献包括三个方面。首先,以基于一阶和二阶方向导数的局部结构特征LSI提取为例,说明了我们从输入图像中提取LSI的独特方法。此外,所提取的LSI具有正确描述图像中完整的局部结构特征的能力。其次,针对FGVC提出了一种新的不需要额外对象标记的LSI学习方法。第三,该方法在5个标准图像数据集(即UFG和UFG)中优于8种最先进的FGVC方法12、花38,鸟类种类9、汽车10,以及飞机11).

本文组织结构如下。在分段中"相关工作,简要介绍了FGVC存在的问题及现有的FGVC方法。在分段中"该方法,在演示了如何从输入图像中提取LSI之后,我们提出了一种新的LSI学习方法。在分段中"实验,我们通过与现有的八种基准方法进行比较,证明了我们提出的方法在六个标准数据集上的性能。

相关工作

FGVC问题有两个方面,首先是如何使给定的网络识别判别区域,其次是如何学习对象的结构。现有的FGVC方法大致可分为两类。在第一类方法中15,16,17,首先对显著性区域进行定位,然后根据所选区域的目标结构信息进行FGVC。值得注意的是,这些方法15,16,17通常会根据边界框或部分注释机制花费大量时间来收集注释。

在第二类方法中3.,4,5,6,7,8,22,39,通过优化神经网络结构确定显著区域。Fu等。39提出了一种注意机制来定位突出区域,然后利用多尺度技术在选定区域学习特征。Yang等。4提出了一种多智能体学习机制来识别信息区域,然后仔细检查所选区域是否存在FGVC。Chen等。5提出了一种破坏与构建学习(DCL)机制,该机制对识别区域和特征有较好的学习能力。Zhou等。7结果表明,识别每个输入图像中不同物体的整体结构有利于定位显著区域。Min等。8放大双线性池化技术40多对象矩阵归一化(MOMN)方法,该方法具有同时正则化基于平方根、低秩和稀疏性的二阶表示的能力。

另外,图像数据增强技术被认为是FGVC的好助手。图像数据增强具有增加训练数据的多样性和数量的功能,有助于降低网络过拟合的几率,提高分类性能。图像数据增强技术可以分为两类。第一组是手动图像数据增强技术,包括图像几何变换、翻转、图像着色、裁剪、旋转、噪声注入和混合图像。第二种是自动增强41,包括自动增强学习42以及随机擦除数据增强43.

该方法

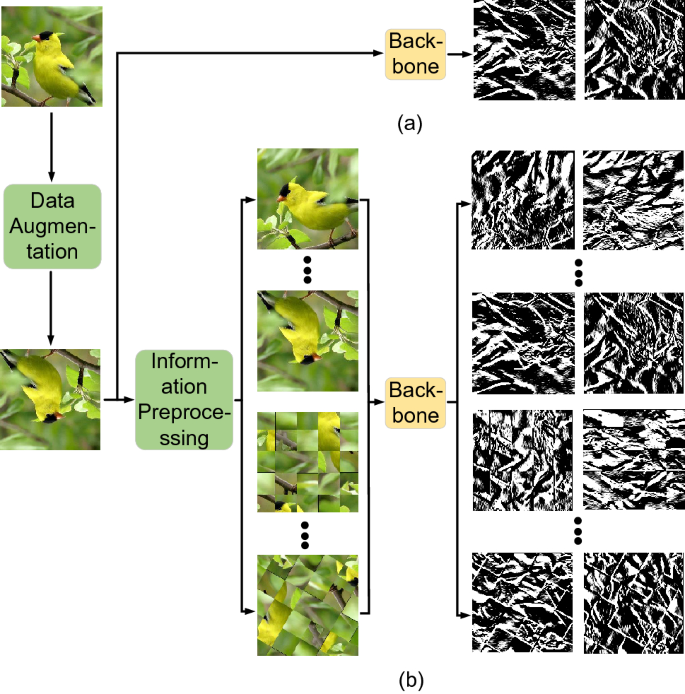

在本节中,我们首先介绍了从输入图像中正确提取LSI的方法,然后提出了一种新的用于FGVC的LSI学习方法。数字1显示了我们所提出的LSI学习框架的总体流程,包括LSI预处理、骨干分类网络、分类网络和局部结构特征相似性度量(LSFSM)四个模块。

大规模集成电路提取

众所周知,在计算机视觉和图像处理中,LSI的精度对输入图像的后续任务有很大的影响。图像的角和边缘作为图像的基本结构特征,一般采用一阶导数来检测25,27,44,和blob一般用二阶导数来检测45.接下来,以这三种基本结构特征检测为例,说明我们如何从输入图像中提取LSI,其中比例因子和各向异性因子都设置为\ \√{1.5}\).

数字2a为测试图像“Building”,其中一个角表示为“\三角洲(\ \)时,一个边点被表示为\盒子(\ \)',而blob则表示为'\ \ bigcirc \ ()”。数字2b-d分别为t型角的FOAGDD、阶跃边的FOAGDD和blob沿不同滤波方向的SOAGDD。从Fig可以看出。2B和c表示方向导数沿滤波方向从0到2的变化\π(\ \)t型角和台阶边不同。即t型角的方向导数有3个局部极大值和3个局部极小值,阶梯边的方向导数只有1个局部极大值和1个局部极小值。数字2b和c也表明水平和垂直滤波方向上的FOAGDD不能区分角和台阶边,这可以用角和边的FOAGDD表示来解释25,28.这种现象提醒我们,输入图像的LSI应该从多个滤波器方向中提取。数字2e是灯光变化后的测试图像“Building”。数字2f-h分别是角的FOAGDD,阶跃边的FOAGDD, blob的SOAGDD。数字2f-h可以清楚地看出,角的FOAGDD在许多滤波方向上都较大,而边缘的FOAGDD和斑点的SOAGDD在许多滤波方向上都较小。因此,雷电条件对LSI的提取以及后续的不同局部结构特征的描述和分类等任务都有很大的影响。

同时,图像旋转21或者图像水平翻转5,7是一种广泛应用于FGVC图像数据增强的操作。将原图像逆时针旋转后\π(\ \)如图所示。2i,从Fig中可以看出。2j-l,即角和边的绝对一阶方向导数和斑点的二阶方向导数等于原始图像上相应位置的值,如图所示。2罪犯。在水平翻转原始图像后,如图所示。2m,由图可见。2N-p,即角和边的绝对一阶方向导数和斑点的二阶方向导数等于原图像上相应位置的值。

通过以上例子,我们可以发现,一些图像数据增强操作可以使局部结构特征的LSI突出,便于分类,而一些图像数据增强操作会使局部结构特征的LSI不突出,便于分类,一些图像数据操作对LSI提取没有影响。此外,多尺度技术16,39也被广泛用于增强LSI提取和执行FGVC。张和孙25,32揭示了现有的多尺度技术只能沿既定的骨干网滤波方向有效地增强LSI提取。从输入图像中提取LSI的关键是沿多个滤波方向提取LSI。这是因为只有沿着多个方向提取每个输入图像的LSI,才能正确描述不同局部结构特征的性质。这意味着在进行FGVC时,我们需要同时对提取的输入图像的不同滤波方向的局部结构信息进行处理。只有这样,我们才能准确地从每张输入图像中提取足够的LSI,用于分析不同显著区域的性质,进行更有效的FGVC。

信息预处理

AEM37是使网络集中学习局部突出内容的有效途径。我们将FGVC的AEM从一维信号扩展到二维信号。对于输入图像我时,我们首先根据图像的中心像素建立其对应的笛卡尔坐标。输入图像被分割成\ (N \ N \)子图像块B我,j在哪里我(\(-\lfloor \frac{N}{2} \rfloor \le i \le \lfloor \frac{N}{2} \rfloor \)),j(\(-\lfloor \frac{N}{2} \rfloor \le j \le \lfloor \frac{N}{2} \rfloor \))分别表示水平指数和垂直指数。然后每个子图像块B(我,j)均匀分布放置在图像中。洗牌后的图像表示为年代.值得注意的是,AEM中经过洗牌后的图像会使网络集中在局部显著区域。但是,AEM会使网络忽略对象的整体结构信息。

我们旋转原始图像我和洗牌图像年代在时间间隔\ \(压裂{\π}{K} \)在…范围内\([0, \压裂{(K - 1) \π}{K}] \),增强了网络学习对象显著局部区域和对象整体结构的能力。然后是一系列旋转的原始图像\ (I_k \)(\(k= 1,2,\dots \),\ (k - 1 \))和旋转洗牌图像\ (S_k \)(\ \ (k = 1 2 \点),\ (k - 1 \))输入骨干网络进行训练。数字3.是一个骨干网的例子,用于提取每个输入图像的一阶强度变化信息。从Fig可以看出。3.a,利用现有的图像数据增强技术,只从每个纪元的每个输入图像中提取沿一对正交方向的LSI。相比之下,随着我们的操作,LSI沿4\ ((k - 1) \)从每个epoch的每个输入图像中提取方位,如图所示。3.b.这样网络就有很大的几率从每张输入图像中获取足够的LSI进行特征学习。这对于现有最先进的FGVC方法来说是不可能的1,2,3.,4,5,7,8,因为他们没有考虑如何使用LSI准确地描述局部结构特征并进行FGVC。实验比较表明,当数据集中的训练图像数量有限时,我们的方法表现得更好。

分类网络

同一类别的不同图像中的物体之间总是存在共性。根据信息预处理模块,对原始图像进行旋转处理\ (I_k \)(\ (k = 1 2 \ ldots \),\ (K_1 \))和旋转后的洗牌图像\ (S_d \)(\ (d = 1 2 \ ldots \),\ (K_2 \))由输入图像转换而成我对于我们的方法。之后是集合\ \ {I_1 \ (),\ \ ldots \ (),\ (I_ {K_1} \),\ (S_1 \),\ \ ldots \ (),\ (S_ {K_2} \ varvec {l} \} \)是培训,在哪里l表示细粒度类别的对应的基本真理单一对所有标签。图像组\ \ {I_1 \ (),\ \ ldots \ (),\ (I_ {K_1} \),\ (S_1 \),\ \ ldots \ (),\ (S_ {K_2} \} \)发送到骨干网以获取相应的特征映射。然后,利用分类网络中的自适应平均池化层和全连通层对特征图进行处理,得到分类分布\ \ {\ varphi (I_1) \),\ \ ldots \ (),\ \ varphi (I_ {K_1}) \),\ (\ varphi (S_1) \),\ \ ldots \ (),\ \ varphi (S_ {K_2}) \} \).这样,分类损失了\ (L_ c {} \)定义为

在哪里C表示用于训练的图像集。

局部结构特征相似性度量

值得注意的是,上述分类网络是通过学习对象的整体和局部信息来进行FGVC。灵感来自于46,引入了不同图像间局部区域的相似性度量,使网络学习到更多物体的LSI,从而获得更好的FGVC。

值得注意的是,在原始图像旋转或打乱后,子图像的位置发生了变化。在信息预处理模块中,有必要对旋转或洗牌后的图像给出一个新的索引。对于每一个旋转的原始图像\ (I_k \)(\ (k = 1, 2 \),\ \ ldots \ (),\ (K_1 \)),其对应的索引(u,v)的子图像块\ (B_k (u, v) \)可由指数(我,j)的原始图像块B(我,j)和旋转矩阵R \ ({\ mathbf {}} _ {k} \)

给定一个子图像块B(我,j)的原始图像我,子图像块的平均灰度值B(我,j)与各子图像块的平均灰度值进行比较\ (S_1 (m, n) \)被打乱的图像\ (S_1 \).索引(我,j)的子图像块B(我,j)被赋给索引(米,n)的子图像块\ (S_1 (m, n) \)当两个子图像的平均灰度值最接近时。这样,索引(米,n)的每个子图像块\ (S_1 (m, n) \)是获得。同时,指数(p,问)的子图像块\ \ (S_d (p, q))旋转后的洗牌图像\ (S_d \)(\ (d = 1, 2 \),\ \ ldots \ (),\ (K_2 \))可由指数(米,n)的图像块\ (S_1 (m, n) \)旋转矩阵R \ ({\ mathbf {}} _ {k} \)用Eq. (2).

在本模块中,的索引\ \ {I_1 \ (),\ \ ldots \ (),\ (I_ {K_1} \),\ (S_1 \),\ \ ldots \ (),\ (S_ {K_2} \} \)用作标签。这组图片\ \ {I_1 \ (),\ \ ldots \ (),\ (I_ {K_1} \),\ (S_1 \),\ \ ldots \ (),\ (S_ {K_2} \} \)发送到骨干网,得到它们对应的特征图。对于每个特征映射,都由1 \ \(1 \倍)卷积层,激活函数Tanh,平均池化层,重塑,排列数组维数,得到每个图像块索引的预测结果。将旋转后的原始图像和旋转后的洗牌图像的指标预测结果记为\((\tau _{k}(u),\tau _{k}(v))\)(\ (k = 1 2 \ ldots \),\ (K_1 \)),\((\varepsilon _{d}(p),\varepsilon _{d}(q))\)(\ (d = 1 2 \ ldots \),\ (K_2 \)分别)。然后利用欧几里得距离,通过计算输入图像的索引标签与其对应的索引预测结果之间的差值来度量局部特征的相似度。

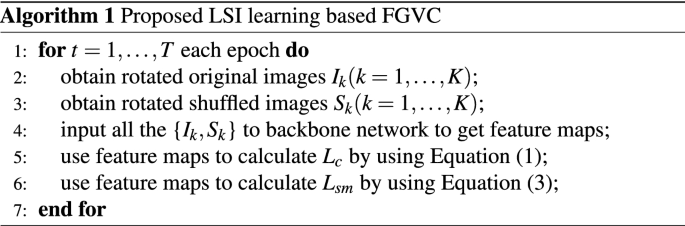

最后,给出了本文提出的基于LSI学习的FGVC算法的伪代码。

实验

在本节中,首先是标准数据集,包括UFG图像数据集12幼崽- 200 - 2011(宝宝)9,斯坦福汽车(CAR)10, FGVC-Aircraft (AIR)11,牛津花(FLO)38,以及植物病害(PD)47,介绍了实验中使用的实验设置。其次,阐述了信息预处理与该方法之间的关系。第三,本文提出的LSI学习方法和ResNet-50等8种最先进的学习方法的性能2, VGG-161, NTS-Net4, fast-MPN-Cov3., DCL5, Cross-X6, MOMN8,及ACNet22,是根据几个实验进行比较的。这些基准测试方法的代码来自于它们的作者。

实验设置

将该方法与上述最先进的基准方法应用于六个图像数据集,并对其分类性能进行比较。此外,我们强调,在我们的实验中,用于训练的唯一注释是图像数据集的分类标签。所提出的方法在Pytorch中实现,使用3.50 GHz CPU和64 GB内存和4个NVIDIA Geforce GTX TITAN X和12 GB内存。

UFG数据集12包括大豆数据集和棉花数据集。棉花数据集包含80个棉花叶片类别,每个类别3个训练图像。它还包括240张图像作为测试数据。大豆数据集包含200个大豆品种的1200张图像。它们分为两部分:600张用于训练的图像和600张用于测试的图像。FLO数据集38包含102类花的8189张图片。这些图像被分为来自102个类的2040个训练图像和6149个测试图像。熊猫幼崽9包含5994个训练图像和5794个测试图像,来自200类鸟类。那辆车10包含8144张用于训练的图像和8041张用于测试196个课程的图像。空气11包含100个类的6667张训练图像和3333张测试图像。对于警局来说47本实验选取38个植物病害类别,5700张训练图像和5700张测试图像。

我们使用vg -161和ResNet-502在我们的方法中作为骨干网。UFG操作12以保持原始物体形状的纵横比。在此操作中,在将输入图像调整为的大小之前,将其填充为正方形440 \ \ 440 \倍)像素,然后随机旋转和裁剪到384 \ \ 384 \倍)像素。所有方法训练160个epoch,使用随机梯度下降,批大小为16。首先,学习率设置为0.001,然后每60个epoch降低10倍。此外,在实验过程中,还根据相应的论文精心细化了基准方法。

参数设置

在我们的调查范围内,UFG数据集12是FGVC中最具挑战性的数据集之一。原因如下。棉花和大豆图像数据集分别包含80个和200个极细粒品种,而每个类别只有3个训练图像。另一方面,它们的类别归属主要由基因决定,人类很难对它们进行准确的分类。以三幅棉花图像为例,如图所示。4,人们很容易对图进行分类。4a和b归为一类,图。4C在另一个类别。事实上,无花果。4b和c属于同一类别,图。4A来自另一个类别。

在本小节中,我们将讨论子图像块数量的选择N以及图像的旋转方向。我们首先将输入图像集固定为\(\{I,I_{\frac{\pi}{4}},S,S_{\frac{\pi}{4}}\}\}\)在不同子图像块数的情况下,检验所提方法的FGVC精度。我表示原始图像,\ (I_{\压裂{\π}{4}}\)表示逆时针旋转的原始图像\ \(压裂{\π}{4}\),年代表示洗牌后的图像,和\ (S_{\压裂{\π}{4}}\)通过旋转表示旋转后的洗牌图像\ \(压裂{\π}{4}\)逆时针方向。从表中可以看出1当时,所提方法性能最佳N是6。

其次,固定子图像块的数量N到6对不同的输入图像集检验所提方法的准确性。数字5表明不同方向的图像旋转次数对FGVC性能影响很大。从图中可以看出。5也就是说,包含4张图像的图像集的性能要优于包含2张图像的图像集。此外,该方法在图像集上的性能最好\(\{I,I_{\frac{\pi}{6}},I_{\frac{\pi}{4}},S\}\)图像设置的最差表现\(\{我I_{\π}\}\),如图所示。5.一方面,有2张图像的图像集的输入图像为我而且\ (I_{\π}\),它们没有提供任何创新,只是为网络提供了相同的LSI(见图。2).另一方面,含有4张图像的图像集的输入图像具有不同的lsi,从而向网络提供更多的信息。这就是图中结果的原因。5.

考虑表中的结果1和无花果。5,我们将子图像块数设置为\ (N = 6 \)而输入图像设为\(\{I,I_{\frac{\pi}{6}},I_{\frac{\pi}{4}},S\}\)在所提出的方法中进行后续实验。

实验结果

表格2展示了我们提出的方法和八个最先进的方法在六个标准数据集上的直接结果。然而,表中有7个数据集2,因为UFG数据集包括大豆数据集和棉花数据集。此外,我们将所提出的方法与ResNet-50的主干进行静态测试,对所测试的方法进行比较。对于CUB数据集,我们提出的方法比ResNet-50提高了1.58%、3.6%、1.55%、0.66%、0.31%、0.56%、3.99%和0.47%2, VGG-161, NTS-Net4, fast-MPN-Cov3., DCL5, Cross-X6, MOMN8,及ACNet22;对于CAR数据集,我们提出的方法比ResNet-50分别提高了1.37%、4.74%、1.97%、3.68%、0.11%、0.11%和6.04%2, VGG-161, NTS-Net4, fast-MPN-Cov3., DCL5, Cross-X6,和MOMN8,准确度与ACNet相当22;对于AIR数据集,本文方法较ResNet-50分别提高1.14%、0.56%、2.73%、0.62%、0.30%、1.04%、5.55%和2.23%2, VGG-161, NTS-Net4, fast-MPN-Cov3., DCL5, Cross-X6, MOMN8,及ACNet22;对于FLO数据集,我们提出的方法比ResNet-50提高了1.81%、2.79%、1.74%、0.83%、0.67%、1.04%、0.01%和0.28%2, VGG-161, NTS-Net4, fast-MPN-Cov3., DCL5, Cross-X6, MOMN8,及ACNet22.表格2表明本文方法的性能优于基准测试方法。这是因为该方法可以使网络从每个输入图像中学习到更多的LSI特征。换句话说,我们提出的方法可以更好地描述图像中不同特征的性质。从表中可以看出2我们提出的方法在棉花和大豆数据集等图像数量有限的数据集上获得了更好的性能。因为在图像数量有限的数据集中,准确提取图像中不同特征的LSI对FGVC的性能影响更为显著。

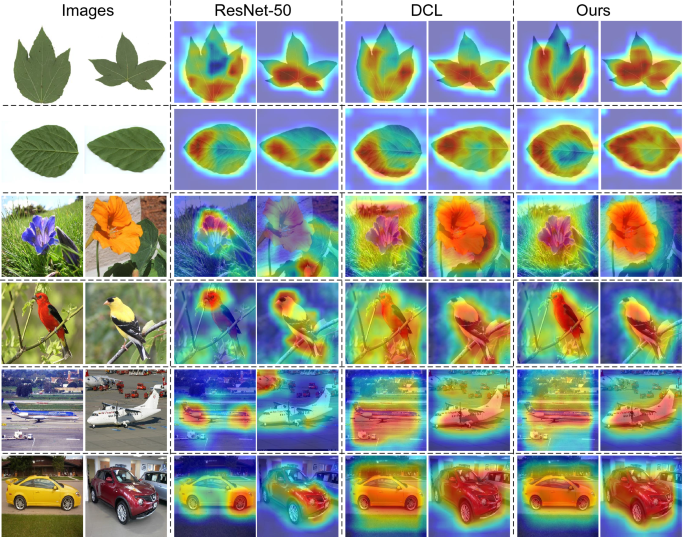

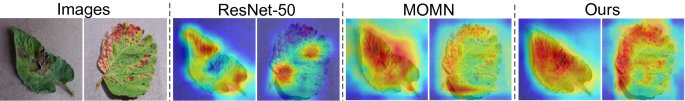

对于UGG、CUB、CAR、AIR和FLO图像,分别为我们方法的最后一层卷积层和两种基准方法(ResNet-50)对应的特征图2和DCL5)如图所示。6.对于PD图像,我们方法的最后一个卷积层和两种基准方法(ResNet-502和MOMN8)如图所示。6.从无花果可以看出。6而且7说明每种方法的特征图有显著差异。与其他三种基准测试方法相比,我们的方法更专注于学习对象的整体结构信息。因此,周围环境对FGVC的干扰可以被有效抑制。

表中的结果2,无花果。6而且7结果表明,本文方法比现有方法具有更好的性能。主要原因是该方法通过沿多个滤波方向提取LSI,可以从输入图像中获得完整的局部结构特征。这样,每个输入图像都有足够的LSI,可以分析不同显著区域的性质,进行更有效的FGVC。也就是说,在给定的骨干网中加入所提出的LSI学习模块,可以增强网络发现显著区域的能力。

此外,我们用PyTorch实现了NVIDIA Geforce GTX TITAN,并报告了我们的推断时间。大小图像上的运行时间\(384 \乘384\)约为31 ms,这意味着我们提出的方法在实际应用中是有效的。

结论

本文针对FGVC提出了一种新的LSI学习框架。首先,阐述了从每个输入图像中准确提取LSI的方法,使网络能够正确描述图像中不同特征的性质。其次,提出了我们的LSI学习框架。第三,将本文方法的性能与八种基准方法进行了比较。仿真结果表明,该方法具有较好的FGVC处理能力。特别是在处理图像数量有限的数据集时,我们提出的方法具有更好的性能。值得注意的是,我们提出的LSI学习机制在用于图像对象检测时并没有明显的性能优势。下面,我们将把所提出的机制扩展到变压器48并将其应用于其他图像处理任务,如物体检测、图像分割和物体跟踪。

数据availibility

支持本文结果的代码由于在表面缺陷检测中的商业应用而无法公开,但可根据合理要求从相应作者处获得。

参考文献

Simonyan, K. & Andrew, Z.用于大规模图像识别的深度卷积网络。在学习表征国际会议论文集770 - 784(2015)。

何凯,张晓霞,任松,孙娟。基于深度残差学习的图像识别方法。在IEEE计算机视觉与模式识别会议论文集770 - 778(2016)。

李鹏,谢军,王强,高忠。基于迭代矩阵平方根归一化的全局协方差池化网络快速训练。在IEEE计算机视觉与模式识别会议论文集947 - 955(2018)。

杨,Z。et al。学习为细粒度分类导航。在计算机视觉欧洲会议论文集420 - 435(2018)。

陈勇,白勇,张文文,梅涛。细粒度图像识别中的破坏与构造学习。在IEEE计算机视觉与模式识别会议论文集5157 - 5166(2019)。

罗,W。et al。用于细粒度视觉分类的交叉x学习。在IEEE计算机视觉国际会议论文集8242 - 8251(2019)。

周敏,白勇,张伟,赵涛,梅涛。面向物体识别的自监督结构建模。在IEEE计算机视觉与模式识别会议论文集11774 - 11783(2020)。

闵晟,姚宏,谢宏,查智俊。张勇。基于多目标矩阵归一化的细粒度视觉识别。IEEE反式。图像的过程。29, 4996-5009(2020)。

Wah, C., Branson, S., Welinder, P., Perona, P. & Belongie, S.加州理工大学ucsd鸟类-200-2011数据集。在加州理工学院(2011)。

邓飞飞,郭文杰,郭文杰。三维对象表示在细粒度分类中的应用。在IEEE国际计算机视觉研讨会论文集554 - 561(2013)。

马吉,S, Rahtu, E, Kannala, J, Blaschko, M. & Vedaldi, A.飞机的细粒度视觉分类。ArXiv: 1306.5151(2013)。

赵昱,X。,,Y。,高,Y。,,美国&元,X的形象结构分类使用multi-orientation区域变换。在人工智能发展协会论文集12741 - 12748(2020)。

彭勇,何晓霞,赵晓明。基于对象-部分注意力模型的细粒度图像分类。IEEE反式。图像的过程。27, 1487-1500(2017)。

崔,Y。et al。卷积神经网络的核池。在IEEE计算机视觉与模式识别会议论文集2921 - 2930(2017)。

Berg, T。et al。Birdsnap:鸟类的大规模细粒度视觉分类。在IEEE计算机视觉与模式识别会议论文集2011 - 2018(2014)。

黄胜,徐震,陶东,张勇,部分堆叠cnn细粒度视觉分类。在IEEE计算机视觉与模式识别会议论文集1173 - 1182(2016)。

金洪亮,杨建军,杨飞飞。一种无部分标注的细粒度识别方法。在IEEE计算机视觉与模式识别会议5546 - 5555(2015)。

李鹏,陆晓霞,王强。从视觉词字典到子空间:局部约束仿射子空间编码。在IEEE计算机视觉与模式识别会议2348 - 2357(2015)。

戴晓霞,吴俊英,戴晓霞,戴晓霞。一阶和二阶信息融合网络在纹理识别中的应用。在IEEE计算机视觉与模式识别会议6100 - 6108(2017)。

柳,S。et al。有限数据着色:通过内存增强网络进行少量着色。在IEEE计算机视觉与模式识别会议论文集11283 - 11292(2019)。

冯志,徐晨,陶东。基于旋转特征解耦的自监督表示学习。在IEEE计算机视觉与模式识别会议论文集10364 - 10374(2019)。

霁,R。et al。注意用于细粒度视觉分类的卷积二叉神经树。在IEEE计算机视觉与模式识别会议论文集10468 - 10477(2020)。

罗超,朱勇,金磊,王勇。学习增强:文本识别的联合数据增强和网络优化。在IEEE计算机视觉与模式识别会议论文集13746 - 13755(2020)。

张伟,孙志刚,张文伟。基于二阶广义高斯方向导数表示的角点检测。IEEE反式。模式肛门。马赫。智能。43, 1213-1224(2021)。

张伟,孙志强。基于多尺度多向结构张量的角点检测。Int。j .第一版。粘度128, 438-459(2020)。

张,观测。,王,f - p。,Zhu, L. & Zhou, Z.-F. Corner detection using gabor filters.IET图像处理。8, 639-646(2014)。

张,W,赵,Y。,Breckon, t . p . &陈l .噪声鲁棒图像边缘检测基于自动各向异性高斯内核。Recogn模式。63, 193-205(2017)。

水,p.l.。&张,w - c。利用各向异性的方向导数表示进行角点检测和分类。IEEE反式。图像的过程。22, 3204-3218(2013)。

张,观测。& Shui, p.l。基于各向异性高斯方向导数主方向角差的轮廓角检测。Recogn模式。48, 2785-2797(2015)。

景俊,刘胜,王国强,张伟,孙昌。图像边缘检测的研究进展。Neurocomputing503, 259-271(2022)。

景俊,高涛,张伟,高勇,孙晨。图像特征信息提取在兴趣点检测中的应用综述。模式分析与机器智能汇刊1(2022)。

张伟,孙春华,张伟强,张伟强。基于离散曲率表示的噪声鲁棒图像角点检测。IEEE反式。图像的过程。28, 4444-4459(2019)。

李勇,毕勇,张伟,孙昌。基于多尺度各向异性高斯核的图像边缘检测。IEEE访问81803-1812(2020)。

水,p.l.。&张,w - c。结合各向同性和各向异性高斯核的噪声鲁棒边缘检测器。Recogn模式。45, 806-820(2012)。

王敏,张伟,孙超。基于Shearlet变换和多向结构张量的角点检测。Recogn模式。103, 107299(2020)。

黄,S.-W。et al。AugGAN:跨域自适应,基于gan的数据增强。在计算机视觉欧洲会议论文集718 - 731(2018)。

兰普尔,A.康诺,L.德诺耶,M.使用单语语料库的无监督机器翻译。ArXiv: 1711.00043(2017)。

尼尔斯巴克,M. & Zisserman .对大量类别的自动花分类。在第六届印度计算机视觉,图形图像处理会议722 - 729(2008)。

傅俊,郑海华,梅涛。近看更清楚:循环注意卷积神经网络用于细粒度图像识别。在IEEE计算机视觉与模式识别会议论文集4438 - 4446(2017)。

林,T.-Y。,RoyChowdhury, A. & Maji, S. Bilinear CNN models for fine-grained visual recognition. InIEEE计算机视觉国际会议论文集1449 - 1457(2015)。

Cubuk, E. D., Zoph, B., Mane, D., Vasudevan, V. & Le, Q. V.自动增强:从数据中学习增强策略。在IEEE计算机视觉与模式识别会议论文集113 - 123(2019)。

李,R.,李,X.,恒,p - a。& Fu, C.-W。Pointaugment:用于点云分类的自动增强框架。在IEEE计算机视觉与模式识别会议论文集6378 - 6387(2020)。

钟忠,郑亮,康国强,李寿,杨阳。随机擦除增强算法。在人工智能发展协会论文集13001 - 13008(2020)。

京,J。et al。一种新的图像边缘检测决策机制。在智能计算理论与应用“,274-287(施普林格国际出版社,2021)。

从尺度不变的关键点来区分图像特征。Int。j .第一版。粘度60, 91-110(2004)。

林玲,王刚,左伟,冯晓霞,张磊。基于广义相似度度量和特征学习的跨域视觉匹配。IEEE反式。模式肛门。马赫。智能。39, 1089-1102(2016)。

Mohanty, s.p., Hughes, d.p. & Salathé, M.使用深度学习进行基于图像的植物疾病检测。前面。植物科学。7, 1419(2016)。

Vaswani)。et al。注意力就是你所需的一切在神经信息处理系统国际会议论文集6000-6010(红钩,2017)。

确认

国家自然科学基金资助项目(61801281)。

作者信息

作者及隶属关系

贡献

J.L.撰写论文,W.Z.构思实验并分析结果,Y.Z.进行实验,C.S.分析结果。所有作者都审阅了手稿。

相应的作者

道德声明

相互竞争的利益

作者声明没有利益竞争。

额外的信息

出版商的注意

施普林格自然对出版的地图和机构从属关系中的管辖权主张保持中立。

权利和权限

开放获取本文遵循知识共享署名4.0国际许可协议,允许以任何媒介或格式使用、分享、改编、分发和复制,只要您对原作者和来源给予适当的署名,提供知识共享许可协议的链接,并注明是否有更改。本文中的图像或其他第三方材料包含在文章的创作共用许可协议中,除非在材料的信用额度中另有说明。如果材料未包含在文章的创作共用许可协议中,并且您的预期使用不被法定法规所允许或超出了允许的使用范围,您将需要直接获得版权所有者的许可。如欲查看本牌照的副本,请浏览http://creativecommons.org/licenses/by/4.0/.

关于本文

引用本文

张陆,J。W,赵,Y。et al。图像局部结构信息学习用于细粒度视觉分类。Sci代表12, 19205(2022)。https://doi.org/10.1038/s41598-022-23835-0

收到了:

接受:

发表:

DOI:https://doi.org/10.1038/s41598-022-23835-0